MimicBrush 是一项由香港大学、阿里巴巴集团和蚂蚁集团联合研发的创新性零样本图像编辑技术。这项技术的核心在于它能够通过模仿参考图像来实现图像编辑,无需任何额外的训练样本。MimicBrush 模型能够智能地识别并匹配参考图像与目标效果,从而实现自动的图像编辑过程。

使用方法简述:

- 上传图像:首先,用户需要上传源图像(source image)和参考图像(reference image)。

- 绘制蒙版:在源图像上,用户通过点击“绘制按钮”(draw button)来指定需要编辑的区域,通常使用白色蒙版(white masks)来标记。

- 启动编辑:完成蒙版绘制后,点击“运行”(run),MimicBrush 将自动开始编辑过程。

实现效果展示:

- 局部编辑(Local Region Editing):对图像的特定区域进行精确编辑,而不影响到其他部分。

- 纹理转移(Texture Transfer):将一种纹理样式应用到另一张图像上,创造出全新的视觉效果。

- 细化处理(Post-processing Refinement):对编辑后的图像进行进一步的细化,以达到更加自然和专业的效果。

MimicBrush 的强大之处在于它的自动化和智能化,用户无需具备专业的图像编辑技能,就能够轻松实现复杂的图像编辑效果。这项技术为设计师、艺术家以及普通用户提供了一个简单易用、功能强大的图像编辑工具,极大地扩展了创意表达的可能性。

(局部编辑)

(纹理转移)

(细化处理)

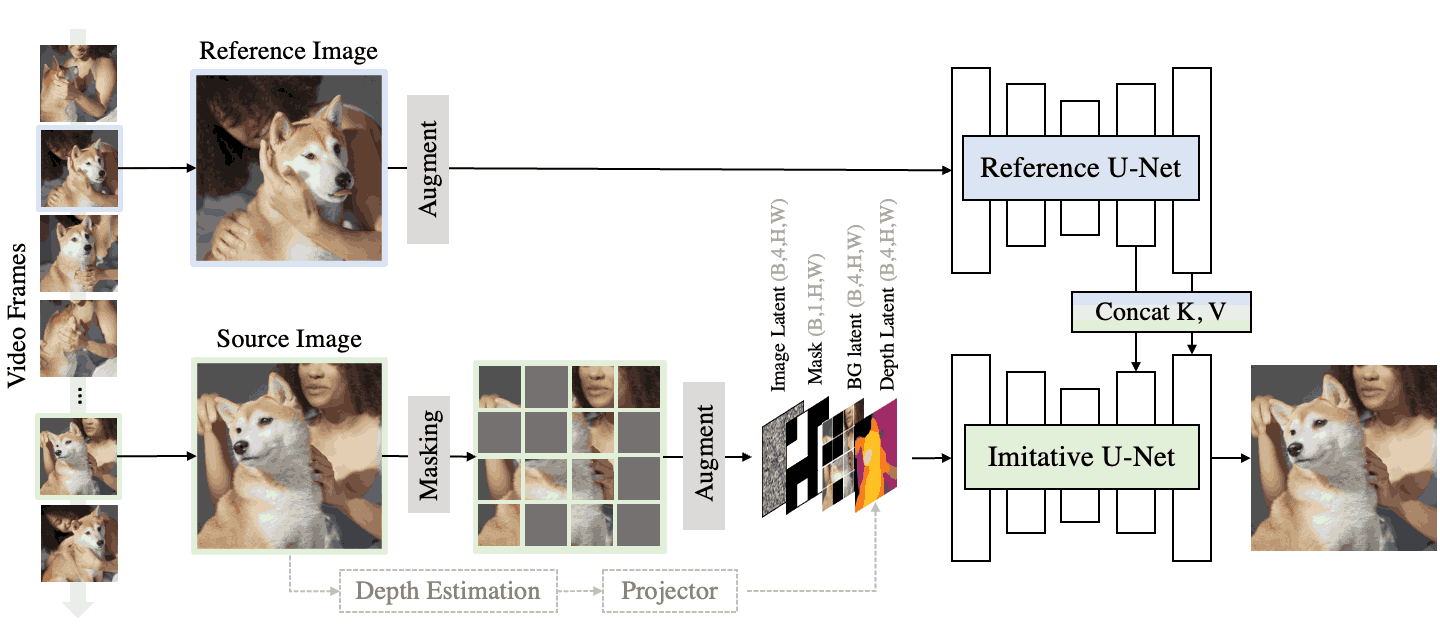

MimicBrush的训练过程:MimicBrush的训练过程。首先,我们从视频序列中随机采样两帧作为参考图像和源图像。然后对源图像进行屏蔽并通过数据增强进行应用。然后,我们将源图像的噪声图像潜在、掩模、背景潜在和深度潜在输入到模拟 U-Net 中。参考图像也被增强并发送到参考 U-Net。对双 U-Net 进行训练以恢复源图像的屏蔽区域。参考 U-Net 的注意键和值与模拟 U-Net 连接起来,以帮助合成屏蔽区域。

模型链接:https://modelscope.cn/models/xichen/MimicBrush

论文链接:https://arxiv.org/abs/2406.07547

Github地址:https://github.com/ali-vilab/MimicBrush?tab=readme-ov-file

Github Page介绍页:https://xavierchen34.github.io/MimicBrush-Page/

魔塔体验地址:https://modelscope.cn/studios/iic/mimicbrush-demo

拥抱脸体验地址:https://huggingface.co/spaces/xichenhku/MimicBrush

小程序体验:#小程序://魔搭社区/7Wtxw6TVSBgwa8s

评论(0)

暂无评论